Introduction

- 我们是否拥有一个可靠的点云自监督学习方法,能在多种任务中仅通过简单的线性探测器就发挥出色?

- “几何捷径(geometric shortcut)”:模型训练初期,模型的损失很快下降到了理想范围,是因为过于依赖于容易获取的几何属性,而不是更高层次的语义。

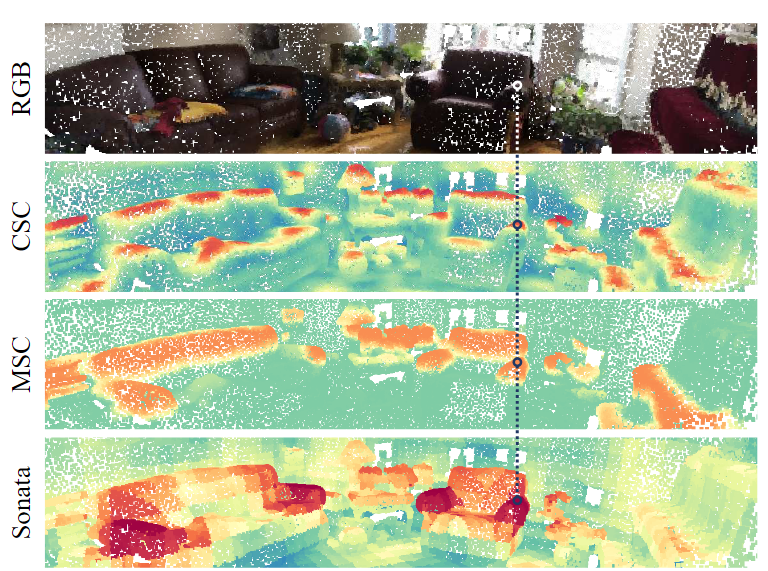

- CSC:只由表面法线(surface normal)**决定

- MSC:过度依赖点的高度(point height)

- Sonata:学习到更抽象、更高层次的语义特征

- 这些几何信息是内嵌在点坐标中的,无法像图像的像素那样容易遮蔽或屏蔽。

- 两种方法解决:

- 模糊空间信息(obscuring spatial information):让模型无法轻易依赖点的坐标、法线、高度等几何属性。

- 强调输入特征(emphasizing input features):鼓励模型关注点的非几何特征(如颜色、语义片段、上下文)或通过更高层任务引导学习更抽象的表示。

- 在更粗的空间尺度上施加自监督损失,比如不是在每个单点上精细对齐,而是在“点簇”或“区域”级别进行训练。

- 干扰被屏蔽点的空间信息+任务难度逐步增加

- 引入了点云自蒸馏框架(point self-distillation)+模型扩展技术(scaling techniques)

- 最终,他们在大规模(14万个场景)的点云数据集上,结合上述方法构建了一个新模型:Sonata。

结果

![[Pasted image 20250707112853.png]](/upload/Pasted%20image%2020250707112853.png)

Related Work

图像自监督学习

- Linear Probing线性探测:在冻结预训练模型(encoder)的情况下,只训练一个线性分类器来完成下游任务(如分类),在某些情况下,例如当分布偏移较大时,线性探测超越了端到端微调效果

- zero-shot visualization零样本可视化:直接看到模型学到什么。

- PCA/t-SNE 可视化:将高维特征降到2D/3D,从而看出哪些样本靠得近(同类)哪些远(异类);

- Attention 可视化:显示模型注意力关注的区域是否对语义有意义,比如一张图中注意力集中在“狗的脸”而非背景

点云自监督学习

- 沿用利用完整场景的信息来学习更丰富的特征

- MSC确实尝试让模型学习超越简单几何线索如点高或法线的特征,具体方法是:在掩码(mask)某些点之后,要求模型去预测这些点的 颜色 或 法线方向

- 模型的训练目标是 人为设定的任务(predefined task),比如预测颜色或法线; 所以最终学到的特征仍然会“锚定”在这些特定信息上,不够通用或语义化。

- GroupContrast(GC),它使用了基于图结构的分组引导方法,它受到其对人工设计的算法的依赖的限制

点云骨干网络

- 然而,编码器和解码器之间的紧密耦合限制了灵活性和泛化能力

- Sonata 通过专门关注编码器来解决这个限制,从而消除了分层解码器

- 过去方法(如 PointContrast、OcCo、MSC)多用 SparseUNet,Sonata 选择使用 PTv3,是一种 transformer-based 点云骨干;能有效捕捉长距离依赖,表达能力更强;

- 仅将 backbone 从 SparseUNet 换成 PTv3,就使得 线性探测精度提升 7.7%;

- 说明结构选择本身对自监督效果影响巨大,特别是当不依赖 decoder 时,encoder 表示能力越强,越能体现出来。

试点研究与设计原理

揭示点云自监督学习中的几何捷径

- “Mode collapse”(模式坍塌):不同输入被映射到相似的表示,造成信息丢失和性能下降。

- 作者推测几何捷径的根源在于点云数据的稀疏性,无论是图像还是点云的操作算子,都需要基于像素/点的坐标来定义卷积核等结构,然而,与规则密集排列的图像像素不同,点云的稀疏性迫使点云操作必须显式使用点坐标,而不能仅靠输入特征。

![[Pasted image 20250708091856.png]](/upload/Pasted%20image%2020250708091856.png) 可以看到去除feature之后,三位点云的几何特征都被保存下来了

可以看到去除feature之后,三位点云的几何特征都被保存下来了

将自监督学习专注于编码器部分

- 具体来说,解码器在原始高分辨率尺度上强制执行逐点特征(因为我们输入多少个点,输出也必须是一一对应的 N 个点特征),具有浅层特征通道(输出的特征维度),而不是像高质量的语义表示那样使用更深层次、更丰富的通道。

- 最关键的是,在原始尺度上解码点云,必然将局部几何信息引入操作中,从而助长几何捷径的形成。

![[Pasted image 20250708093011.png]](/upload/Pasted%20image%2020250708093011.png) Encoder 学到的是多样且分散的特征模式,说明它提取了广泛的信息,随着点云变得更粗(分辨率降低是因为通过 max pooling / downsampling,点云稀疏化),点坐标中包含的几何信息也变得更全局化,这种分辨率降低从根本上限制了对与点坐标相关的精细空间信息的依赖。相反,decoder 学到的表示更均匀、结构化,说明它更专注于为特定任务(如分类)精炼特征

Encoder 学到的是多样且分散的特征模式,说明它提取了广泛的信息,随着点云变得更粗(分辨率降低是因为通过 max pooling / downsampling,点云稀疏化),点坐标中包含的几何信息也变得更全局化,这种分辨率降低从根本上限制了对与点坐标相关的精细空间信息的依赖。相反,decoder 学到的表示更均匀、结构化,说明它更专注于为特定任务(如分类)精炼特征- 移除decoder的两个原因:首先,直接使用较粗点分辨率下的特征进行训练固有地限制了对细粒度空间信息的访问,降低了几何捷径的可能性。其次,特定于任务的特征可以在更具表现力的多尺度点表示之上进行探测或微调,预训练学的是通用知识(如形状、结构),这样更好

Sonata 方法(点云自蒸馏框架)

宏观框架

- 本质上,点云自监督学习的目标是:让本应相同的点(语义上相同的),在特征表示上也保持一致

- 构成了点云自监督学习的基本流程:对同一个点云生成两个视图,施加空间(如裁剪、旋转、形变)和光学(如抖动)增强,然后将原始空间中相邻的点的特征向量进行匹配和对齐

- 自监督表示的强鲁棒性源于一个核心原则:只要模型还能收敛,就持续提升预训练任务的难度,推动我们在基础框架上引入“局部-全局对齐”和“掩码-非掩码对齐”

- 蒸馏的三大步骤

![[Pasted image 20250708102420.png]](/upload/Pasted%20image%2020250708102420.png)

- 视图生成阶段:生成三种视图:Local View(左下):小裁剪;Global View(右):保持大范围内容;Masked View(左上):在全局视图上打掩码

- 特征提取阶段:使用 student 网络 对局部视图 & 掩码视图进行特征提取;使用 teacher 网络 对全局视图提取语义表示;

- 特征对齐与蒸馏阶段:用原始点云中的坐标距离判断“谁是语义上相同的点”;将从小裁剪比例生成的局部视图中的邻近点,和从大掩码比例生成的遮掩视图中的点,与未掩盖的全局视图中的点对齐一旦找到了匹配点,student 的表示就要去“模仿” teacher 给出的 embedding;这就是蒸馏过程:student 向 teacher 学特征。

- 自监督学习会逐渐提高任务难度,这些任务太难时,模型可能完全找不到“语义对齐”信号,导致学不到有用的东西,表现为 “特征坍塌(collapse)

- 解决方式:这种不稳定性需要一种非对称编码方法,指数移动平均 (EMA) :该方法不是使用共享权重模型对所有视图进行编码,而是使用主动学习的学生模型对具有挑战性的本地和掩码视图进行编码,同时使用稳定的教师模型,使用学生参数的移动平均进行更新,以编码全局视图。

- 通过 teacher 的稳定引导,student 有可能:不被困难数据击垮;在极少上下文信息中,强迫性地学到真正鲁棒的全局语义特征;

- 解决方式:这种不稳定性需要一种非对称编码方法,指数移动平均 (EMA) :该方法不是使用共享权重模型对所有视图进行编码,而是使用主动学习的学生模型对具有挑战性的本地和掩码视图进行编码,同时使用稳定的教师模型,使用学生参数的移动平均进行更新,以编码全局视图。

- 我们借鉴了 DINOv2 的方法,采用一种 自蒸馏(self-distillation)策略,它结合了以下三项技术:Sinkhorn-Knopp centering , KoLeo regularization and clustering assignments ,这种方法起初容易加剧模型坍塌为“几何捷径”,但一旦解决这种坍塌问题,它就具有更强的潜力去学习鲁棒的、泛化性强的特征表示。

微观设计

解码器移除

- 通过只用 encoder 的输出,我们能用更多通道(由96提升到512)参与自蒸馏任务。

- 去掉 decoder,经过层级下采样(hierarchical pooling)之后只保留少量点参与预训练任务,这使得整体流程更加简洁高效。

- 最关键的一点:通过层级下采样和编码处理后,点的原始几何位置已经被打乱,自然地模糊了原始的几何线索。(相当于mask了位置)

- 效果很好:在线性探测(linear probing)实验中,准确率由 20.7% 提升到了 60.4%。

特征上投

-

移除了解码器,带来一个问题:模型难以利用多尺度上下文信息。

-

原始的 U-Net 结构中,decoder 的核心作用是逐步将不同尺度的特征融合起来,从而重建语义细节,自蒸馏很难捕获多尺度空间信息和更广泛的上下文关系

- 解决方法:引入了一种无参数的上投特征(feature up-casting)机制,其思想类似于图像语义分割中的 hypercolumns,来自不同层(不同尺度)的位置处的特征拼接成一个超长的向量

- 特征被逐层上投,恢复到上一层编码阶段的尺度,过程中:

- 通过下采样(pooling)记录每层之间的点映射关系;

- 使用这些映射关系,在上投时把低层特征送回到高层点的位置;

- 再与该层的原始特征拼接(concatenation)。

- 当然,这种特征上投也可能重新引入几何捷径的风险(因为重新结合了位置敏感的浅层特征),上投两次效果是最好的

对被 mask 的点加入更强的扰动

- 作为数据增强的一部分,将轻微的随机高斯抖动 (σ = 0.005) 应用于点坐标。然而,特别是对于要掩盖的点,我们还应用了更强的高斯抖动 (σ = 0.01) 来进一步破坏它们的空间关系。

- 原因:是故意打断模型利用“几何坐标”来预测掩盖特征的捷径,迫使它从上下文中学习真正的结构语义。

渐进式参数调度器

- 我们不是从具有挑战性的大掩码大小和掩码比率开始,而是从相对较小的掩码大小 (10 cm) 和掩码比率 (30%) 开始,在前 5% 的训练过程中,逐渐将它们增加到 40 cm (0.1 ⇒ 0.4) 和 70% (0.3 ⇒ 0.7),让其更多依赖特征来学习而不是几何特征

- 另外还对其他参数teacher temperature(0.04 ⇒ 0.07)和weight delay(0.04⇒ 0.2)进行循序渐进的更新

实现细节与评估协议

主干网络选择

- Sonata 采用的主干网络是 Point Transformer V3(PTv3),这是一个用于点云处理的先进模型。

- 将模型中的所有 BatchNorm 替换为 LayerNorm,虽然可能导致初期精度下降,但从长期来看带来更好效果

- 跨域(cross-domain)训练时,不同数据集的特征分布差异大,BN 的统计量是全局共享的,但各 domain 的分布不同

- LayerNorm对每个样本自己归一化,虽然刚开始换成 LN 可能让模型准确率稍微下降(因为它不再依赖大批次统计量);但它更适合多数据集联合训练;不需要为不同数据集额外调 BN 的参数,提升了模型在不同 domain 上的泛化能力

- 还进行了模型扩容随着数据的扩大,我们还将编码器块深度从[2,2,2,6,2]扩展到[3,3,3,12,3],宽度从[32,64,128,256,512]扩展到[48,96,192,384,512]。这个PTv3模型有108M个参数,感受野更大,表达能力更强

数据

- 他们在 PPT(一个点云预训练框架)提出的“多数据集联合训练”基础上继续扩展,收集了 14 万个场景级别的点云数据;包括真实世界(实景)的点云,也包括模拟环境(仿真)生成的点云

![[Pasted image 20250708140659.png]](/upload/Pasted%20image%2020250708140659.png)

![[Pasted image 20250708140837.png]](/upload/Pasted%20image%2020250708140837.png) 可以看到数据更大

可以看到数据更大

训练

- 训练了 200 个 epoch;使用的是 AdamW 优化器(带权重衰减的 Adam,常用于 transformer 结构);Batch Size = 96,在 32张GPU 上并行训练,每张 GPU 平均跑 3 个样本。

- 前 10 个 epoch 做 线性 warm-up(平滑启动学习率)→ 避免刚开始权重震荡;达到基础学习率 0.004 后,后续学习率 按余弦下降(cosine decay),让训练后期逐渐收敛。

- 不同层使用不同学习率:第 i 层的学习率 = base_{lr} × 0.9^i

- 越靠近输入层,学习率越小,越靠近输出层,学习率越大;

- 权重衰减(正则项) 不再固定,而是从 0.04 增长到 0.2;用于防止过拟合,同时在训练后期增强正则约束。

- student temperature设置为 0.1,而teacher temperature在前 10 个 epoch 中逐渐从 0.04 增加到 0.07。动量m从 0.994 开始,并通过最终迭代增加到 1。θt←m⋅θt+(1−m)⋅θs

- 对于数据增强和视图生成,我们遵循 MSC 设计的增强管道。我们生成 2 个全局视图(采样 40% 到 100% 的场景点)和 4 个局部视图(采样 5% 到 40% 的场景点)进行训练,其中 2 个基于全局视图生成的掩码视图。

评估

- Linear Probing(线性探测)主要评估标准

不更新预训练的 encoder,只是从它里面提取特征,用一个简单(总参数不到 0.2%)的 线性分类头(Linear Layer) 来把特征映射到任务输出 - Decoder Probing(轻量解码器探测)

不训练 encoder,只重新接上一个小 decoder,让它学着“解读” encoder 提供的特征;decoder 学着理解 encoder 的输出,用于预测下游任务,用于 检测多尺度结构信息是否有效保留。(只有解码器学习) - Full Fine-tuning(完整微调)

encoder + decoder 全部打开,一起更新,利用预训练作为“起点”,再继续学下游任务;

主要结果

与图像自监督模型的比较

![[Pasted image 20250708143438.png]](/upload/Pasted%20image%2020250708143438.png)

- 这里用真实的相机姿态(ground truth poses)和通过射线与重建网格交叉计算出的深度来做点云重投影;

- 这样投影的点云特征比直接用传感器采集的单帧深度更准确,保证评测公平和准确。

- 实验结果:Sonata 在点云语义分割上更适合3D任务

- 在 ScanNet 上 比 DINOv2 提升了 9.2%(线性探测准确率);在 ScanNet200 上提升了 1.5%。

- 将 Sonata(点云模态)和 DINO(图像模态)的表示结合(跨模态融合);

- 零样本(zero-shot)实验

![[Pasted image 20250708143901.png]](/upload/Pasted%20image%2020250708143901.png) DINOv2侧重图像的光学信息,Sonata侧重三维空间结构;结合这两者的特征,模型在表示能力上更强,能够同时兼顾视觉和空间信息;

DINOv2侧重图像的光学信息,Sonata侧重三维空间结构;结合这两者的特征,模型在表示能力上更强,能够同时兼顾视觉和空间信息;

数据效率

![[Pasted image 20250708144255.png]](/upload/Pasted%20image%2020250708144255.png)

- 使用 ScanNet 数据集做语义分割任务

- 与从头开始训练相比,Sonata 在极端数据稀缺(1% 的场景))中提高了 19.5%,在极端数据稀缺(每场景 20 点标注)方面提高了 10.4%。值得注意的是,即使是线性探测也大大超过了以前的 SOTA(1% 场景为 12.5%),突出了 Sonata 在低数据场景中的可靠性。

参数效率

![[Pasted image 20250708144806.png]](/upload/Pasted%20image%2020250708144806.png)

- 我们使用线性和解码器探测在各种室内语义分割基准上演示了参数效率,包括ScanNet、ScanNet200、ScanNet++、S3DIS Area5和S3DIS 6倍交叉验证。强调语义分割,因为它提供了点云表示质量的直接度量。

- 结果表明,具有可忽略不计参数数量(总参数 <0.02%)的单个线性层足以使 Sonata 在这些基准上实现强大的性能。此外,仅使用 13% 模型参数探测解码器会产生更高的精度

- 然而,虽然解码器探测在ScanNet(20个类)和S3DIS(13个类)上实现了SOTA结果,但在ScanNet200(200个类)和ScanNet++(100个类)上的性能仍然有限。这显示了学习表示在区分大量类方面的局限性。

室内语义分割

![[Pasted image 20250708145542.png]](/upload/Pasted%20image%2020250708145542.png)

- 采用的是全模型微调的评估方式,在5个被广泛认可的基准中,一致地将SOTA结果推向新的高度,然而,我们将完全微调视为迈向线性探测超越它的未来中间步骤,未来还是靠线性的达到SOTA,目前还是有差距

室内实例分割

![[Pasted image 20250708145957.png]](/upload/Pasted%20image%2020250708145957.png)

- 三种评估方法都用了,full达到了SOTA

- mAP50:表示预测框与真实框 IoU 超过 50% 时的平均精度,越高越好。

- 说明Sonata 的表示里已包含“每个物体实例”的细粒度区分能力

户外语义分割

![[Pasted image 20250708150535.png]](/upload/Pasted%20image%2020250708150535.png)

- 虽然 decoder probing 的参数量比 full fine-tuning 少得多(encoder 是冻结的),但表现几乎一样;

跨场景 zero-shot 表征验证

![[Pasted image 20250708150835.png]](/upload/Pasted%20image%2020250708150835.png) 我们在HM3D的房屋尺度点云上提供PCA映射的颜色和密集匹配(五个代表点标记为×,沙发扶手、椅子、桌子、靠垫、边桌),包括2楼层和12个房间(左:楼层1,右:地板2)。

我们在HM3D的房屋尺度点云上提供PCA映射的颜色和密集匹配(五个代表点标记为×,沙发扶手、椅子、桌子、靠垫、边桌),包括2楼层和12个房间(左:楼层1,右:地板2)。

- Zero-shot:模型没有在目标任务或场景上训练,直接使用预训练的表示能力来做理解;

- 这个数据集非常适合验证模型的跨空间泛化能力

- 表征可视化方式:

- PCA + 彩色映射

- 把每个房间的点云单独送入 Sonata 编码器;用 PCA 把高维表示降到 3D(映射为 RGB 颜色);颜色相似 → 表示相似 → 表示语义结构一致。

- 密集匹配

- 从场景中选出 5 个点(如沙发扶手、桌子、椅子、靠垫、边桌);用这些点的特征去和整个屋子里的所有点做相似度计算;把相似点高亮出来,形成 dense matching 图。

- PCA + 彩色映射

- 这个过程相当于做了zero-shot 语义搜索 / 语义匹配,验证特征是否具有跨空间、一致、语义细粒度表达能力。

- 可视化表明,Sonata 在不同的室内环境中始终提供语义丰富且信息丰富的表示。同类物体的特征自然聚在一起,特征分辨率高,能区分物体细节,无监督也能完成有意义的点匹配和语义推理;

结论和讨论

- 从点自蒸馏框架开始,我们通过在较粗的空间尺度上附加SSL损失来解决几何捷径,干扰没有特征的掩码点的空间信息,逐步增加任务难度,以防止过度依赖可访问的几何线索。这种变化可以有效地扩大规模,最终从 140k 点云中组成 Sonata。Sonata 展示了语义上有意义的零样本可视化,以及卓越的参数和数据效率。完全微调进一步推进了3D室内和室外感知任务的SOTA

局限性和未来研究方向

-

增强语义丰富性:训练只使用了场景级点云(如 ScanNet、S3DIS),没有利用丰富的 对象级资产(object-level assets),可以引入公开的 100万个物体级点云数据(如 [53] 提到的 ShapeNet-like dataset);通过这些高质量单物体点云,可以增强模型对「对象细节」的理解,提高跨实例和跨场景语义表达力;

-

统一室内/室外训练:目前的预训练分别针对室内(ScanNet 等)或室外(Waymo、SemanticKITTI);避免了跨域训练的问题,但限制了模型泛化能力,

- 主要挑战在于点密度和输入特征:点密度可以通过缩放来对齐,同时增强室外激光雷达数据,给 LiDAR 数据增加颜色(lifted image) 和 伪法向量(从雷达视角推算)。此外,对这些特征应用随机噪声和掩蔽可以进一步提高泛化能力。

-

与视频数据结合:与视频数据相比,自然三维点云数据集具有固有的尺度限制

- 我们的目标是以两种方式利用视频数据集:

- 使用图像深度估计将静态视频帧转换成密集对齐的点云

- 使用 SLAM 算法从动态第一人称视频中生成稀疏点云 。这种方法为大规模、真实世界的不同场景进行培训开辟了新的可能性

-

跨模态蒸馏:实验发现DINOv2(图像自监督模型) 与 Sonata(点云模型)表达互补语义;两者结合能获得更强的特征

- 将 DINOv2 的图像特征 lift 到 3D,作为蒸馏信号;在 Sonata 的自监督训练中引入这些图像特征,进行 cross-modal distillation;更进一步,可以发展一个统一的多模态自监督框架:同时进行 point ↔ image 双向蒸馏,构建丰富的 multi-view 多模态表示。

评论区